ChatGPT、Claude、Gemini——。生成AIは弁護士業務を劇的に効率化する可能性を秘めています。契約書のレビュー、訴状のドラフト、法律相談への回答。すでに多くの先生方が、何らかの形で生成AIを業務に取り入れ始めているのではないでしょうか。

しかし、ここで一つ、決定的に重要な問いがあります。

そのAIに、依頼者の氏名・住所・事件内容をそのまま入力していませんか?

「便利だから使っている」「みんな使っているから大丈夫だろう」——そう考えている先生方にこそ、本記事をお読みいただきたいのです。2024年から2026年にかけて、AIへの個人データ入力をめぐる世界の規制環境は劇的に変化しました。EU AI Actの段階的発効、イタリアによる生成AI初のGDPR罰金、韓国によるAIモデル削除命令、そして日本でもAI推進法の成立と個人情報保護法の改正議論が進行中です。

本記事では、弁護士が生成AIを安全に利用するために知っておくべき世界7か国の最新規制動向を網羅的に解説し、実務上の具体的な対策を提示します。

なぜ今、この問題が重要なのか —— 「法律がないからこそ怖い」という逆説

まず、日本の弁護士が直面している状況を正確に理解しましょう。

現在、日本には「生成AIへの個人データ入力を明示的に禁止する法律」は存在しません。2025年5月に成立したAI推進法は促進法であり、罰則もありません。個人情報保護法(APPI)は生成AI以前に設計された法律であり、ChatGPTへのプロンプト入力という行為を直接想定していません。

一見すると「問題ない」ように見えます。しかし、これは安心材料ではなく、むしろ最大のリスク要因です。

法律がないということは、何が許され何が許されないかの線引きが曖昧だということです。 そして曖昧なまま利用を続けた結果、後から規制が明確化されたとき、過去の利用が遡及的に問題視される可能性があります。実際にEUではそれが起きています。

さらに、弁護士には一般企業とは異なる特別な義務があります。弁護士法第23条に基づく守秘義務です。依頼者の秘密を正当な理由なく漏洩すれば、刑事罰(6か月以下の懲役または50万円以下の罰金)の対象となります。ChatGPTに依頼者情報を入力する行為が「漏洩」に該当するかどうか——この問いに対する明確な判例はまだありません。しかし、日弁連のAI戦略ワーキンググループは、クラウドベースのAIサービスへの依頼者情報の入力は「外部サーバーへのデータ送信に該当し、機密漏洩リスクを生じさせる」と明確に警告しています。

つまり、「法律で禁止されていないから大丈夫」という論理は、弁護士業務においては成り立たないのです。

世界の規制動向を見れば、この問題の深刻さはさらに明確になります。順を追って見ていきましょう。

第1章:EU —— AI規制の世界標準を形成する「二重規制体制」

EU AI Act:GDPRを超える罰金と段階的義務

EUは世界に先駆けて包括的なAI規制を整備しました。EU AI Act(規則2024/1689)は2024年8月1日に発効し、段階的に適用が進行しています。

適用スケジュールを整理すると、2025年2月2日に禁止AI慣行(社会スコアリング、無差別顔認識スクレイピング等)とAIリテラシー義務が発効済みです。2025年8月2日には汎用AI(GPAI)の透明性義務と罰則制度が適用開始されました。そして次の重大マイルストーンは2026年8月2日で、高リスクAIシステムの義務——適合性評価、リスク管理、データガバナンス——が適用されます。

弁護士にとって特に重要なのは以下の3点です。

第一に、GDPRとの完全な並行適用です。 EU AI Actの第2条第7項は、GDPRの義務がAI Actと完全に並行して適用されることを明記しています。つまり、AI Actを守っていてもGDPR違反は免責されません。AIを使う限り、常にGDPRの義務も同時に満たさなければならないのです。

第二に、データガバナンス要件の厳格さです。 第10条は、高リスクAIの訓練データにおける特別カテゴリー個人データ(人種、健康情報、性的指向等)の処理に、仮名化等の厳格な保護措置を要求しています。法律サービスは「高リスク」カテゴリーに含まれる可能性があり、弁護士が使うAIツールも対象となり得ます。

第三に、罰則の重さです。 禁止AI慣行への違反は最大3,500万ユーロまたは全世界年間売上高の7%(いずれか高い方)。これはGDPRの上限(2,000万ユーロ/4%)を大幅に超えます。

EDPB意見28/2024 —— 「モデル削除」の可能性を示した画期的見解

2024年12月17日に欧州データ保護委員会(EDPB)が採択した意見28/2024は、AI開発者と利用者の双方に決定的な影響を与える文書です。

この意見は3つの重要な判断を示しました。第一に、AIモデルが訓練データに含まれる個人を特定し得ないことが「極めて低い確率」でない限り、そのモデルは匿名とはみなされません。第二に、正当利益(GDPR第6条第1項(f))はAI開発・展開の法的根拠となり得ますが、3段階テスト(正当利益の存在→必要性→利益衡量)を厳格に充足する必要があります。第三に、開発段階で違法に処理されたデータに基づくモデルについて、監督機関は罰金のみならずモデル削除を命じ得るとされました。

この第三の判断は極めて重大です。違法にデータを収集してAIを訓練した場合、罰金だけでなく、そのAIモデル自体を削除しなければならない可能性があるということです。後述する韓国の事例では、これが現実に起きています。

Digital Omnibus on AI提案 —— 緩和の動きも

2025年11月19日に欧州委員会が公表した「Digital Omnibus on AI」提案には、高リスクAI義務の適用期限を2027〜2028年に延期する可能性が含まれています。また、通常の個人データをAI開発・利用に使用することを、無条件のオプトアウト権を条件として認める規定も提案されています。ただし、この提案は通常立法手続きの途上にあり、2026年後半の正式採択が見込まれる段階です。

第2章:Grok事件 —— 「オプトアウト方式」の限界が確定した瞬間

EUの規制がどれほど「本気」かを理解するために、X(旧Twitter)のAIチャットボット「Grok」をめぐる事件を詳しく見ましょう。この事件は、AI時代の個人データ保護における最も重要なケーススタディの一つです。

事件の経緯

2024年5月、XはEU/EEAユーザー約6,000万人の公開投稿をGrokの訓練に使用し始めました。ユーザーへの通知も同意取得も行われませんでした。7月になってようやくオプトアウト設定が追加されましたが、デフォルトでオンに設定され、設定画面にたどり着くまでに7ステップもの操作が必要な深い階層に隠されていました。

この問題が2024年7月26日にユーザーによって暴露されると、事態は急速に展開しました。

8月6日、アイルランドのデータ保護委員会(DPC)は史上初めてリード監督機関としての緊急権限を行使し、アイルランド高等裁判所に緊急手続きを申し立てました。8月8日にはXがEU/EEAユーザーデータの処理停止に合意。9月4日には恒久的な約束として、公開投稿のGrok訓練目的利用の恒久停止とデータ削除を受け入れました。

しかし、既に訓練されたAIモデル自体の削除は命じられませんでした。これは重大な「抜け穴」として議論を呼んでいます。

その後の展開 —— 調査は拡大の一途

DPCは2025年4月に過去の処理の合法性を問う正式な法定調査を開始しました。2025年末から2026年にかけてはGrokの画像編集機能による非同意型ディープフェイク生成問題が発生し、2026年2月17日には新たな大規模調査が開始されています。

さらに、プライバシー団体NoyBは9か国のデータ保護機関にGDPR違反の苦情を提出。欧州委員会もデジタルサービス法(DSA)に基づく調査を開始し、2025年12月にはDSA違反で1億2,000万ユーロの罰金を科しました。フランスでは2026年2月にX社パリオフィスへの家宅捜索が行われ、刑事捜査にまで発展しています。

この事件が弁護士に教えること

Grok事件の最大の教訓は明確です。オプトアウト方式では、AI訓練目的の個人データ処理の合法性を確保できないことが実務上確立されました。

「設定でオフにできるから大丈夫」「利用規約に書いてあるから問題ない」——こうした言い訳は通用しません。この事件の直接的な影響として、Metaが2024年6月にEUでのAI訓練計画を一時中断する事態に至っています。

弁護士にとっての含意は重大です。ChatGPTやClaudeの利用規約に「データを訓練に使用しない」と書いてあったとしても、それだけでは依頼者の個人データを入力することの法的正当性を完全には担保できません。サービス提供者の約束と法的義務は別の問題だからです。

第3章:各国の規制動向 —— 「収斂」する世界の方向性

イタリア —— 西側諸国で初めてChatGPTを禁止した国

イタリアのデータ保護庁(ガランテ)は2023年3月30日、ChatGPTの一時禁止措置を講じました。西側諸国で初の事例です。根拠は訓練データの法的根拠の欠如、透明性不足、年齢確認の不備、データ侵害の未通知でした。

OpenAIはプライバシーポリシーの拡充、オプトアウトフォーム、年齢確認の実装を条件に約1か月後にサービスを復旧させましたが、ガランテの調査は継続しました。そして2024年12月20日、生成AIに対する世界初のGDPR罰金として1,500万ユーロが科されました。ChatGPTはイタリアで現在完全に稼働していますが、OpenAIは控訴中です。

この事例が示しているのは、AIサービスが「使えている」ことと「合法である」ことは必ずしも同義ではないということです。

韓国 —— 世界最先進の「AIモデル削除命令」

韓国の個人情報保護委員会(PIPC)は、世界で最も積極的なAI執行機関の一つとなっています。

2021年のScatter Lab事件では、AI「イルダ」の訓練に94億件のカカオトークメッセージが無断使用され、罰金が科されました。2024年11月にはMetaに216億ウォンの罰金。

そして2025年1月のカカオペイ/Alipay事件が、世界のAI規制において画期的な先例となりました。83億ウォンの罰金に加えて、AIモデル(アルゴリズム)自体の削除が命じられたのです。

これは欧州をも超える執行です。違法に収集されたデータで訓練されたAIモデルの「果実」——つまり学習済みモデルそのもの——も違法であるという立場が明確にされました。EDPB意見28/2024が理論的可能性として示したものを、韓国は現実の執行として実行したのです。

韓国では2024年12月にAI基本法が制定され、2026年上半期に施行される予定です。

台湾 —— 政府職員のAI利用を明確禁止

台湾は2025年12月23日にAI基本法を可決し、プライバシーとデータガバナンス、データ最小化、プライバシー・バイ・デザインを7つの中核原則に含めました。

特筆すべきは2023年8月の行政院ガイドラインです。政府職員が機密文書に生成AIを使用することを明確に禁止し、個人データや機密情報のAIへの入力も禁止しています。 台湾の弁護士業界もこの方針に影響を受けており、機密性の高い情報のAI入力に対する慎重姿勢が広がっています。

ドイツ —— 「クローズドAIシステム優先」の実務指針

ドイツでは16州のデータ保護機関が協調するDSK(データ保護監督機関会議)が主導的役割を果たしています。

2024年5月に公表されたDSK生成AIガイダンスは実務的に極めて重要な文書です。このガイダンスは、クローズドAIシステムの優先使用(外部にデータを送信しないシステムを使うべき)、プロンプト履歴と訓練へのデータ利用のデフォルト無効化、データ保護影響評価(DPIA)の「頻繁な」実施を明記しています。

2025年9月にはハンブルクのデータ保護機関がAI駆動の自動意思決定で49万2,000ユーロの罰金を科し、ドイツ初のAI関連執行罰金となりました。

コロラド州AI法 —— 米国初の包括的AI規制

米国では連邦レベルの包括的AI規制がない中、コロラド州が先行しています。コロラド州AI法(SB 24-205、通称CAIA)は2024年5月にポリス知事が「留保付き」で署名した米国初の包括的AI消費者保護法です。当初の施行日は2026年2月1日でしたが、特別立法セッションを経て2026年6月30日に延期されました。

適用対象は教育、雇用、金融、医療、住宅、保険、法律サービス、政府サービスに関する「重大な決定」を行うAIシステムです。ChatGPT等の汎用生成AIは、これらの重大な決定に使用されない限り直接の適用対象外ですが、AIが重大な決定に寄与する場合、利用者には処理個人データの種類・データソースの開示、不正確なデータの訂正機会の提供、プロファイリングに対するオプトアウト権の告知が義務付けられます。

注目すべきは、2025年12月のトランプ大統領令がコロラド州AI法を名指しで「問題あり」と批判したにもかかわらず、法律専門家は大統領令のみで州法を無効化することはできないと指摘している点です。州レベルのAI規制は当面維持される見通しです。

第4章:日本の現状 —— 「世界一AIフレンドリー」の裏側

日本の規制哲学:ソフトロー・アプローチ

日本は「世界一AIフレンドリーな国」を標榜し、EUの包括的ハードローとは対照的なソフトロー・アプローチを採用しています。しかし、個人データ保護の観点では着実に制約が強化されています。

個人情報保護委員会(PPC)は2023年6月2日、OpenAIに対し注意喚起を発出しました。 要配慮個人情報(人種、信条、病歴等)をユーザー・非ユーザーから事前同意なく収集しないこと、機械学習用データ収集時に要配慮個人情報の混入を防ぐ必要措置を講じること、利用目的を日本語で通知・公表すること——これらが主な要求事項でした。PPCは「現時点でAPPI違反は確認されていない」としつつ「追加措置の権利を留保」しており、いつでも執行に転じ得る状態にあります。

AI事業者ガイドラインとAI推進法

経済産業省・総務省が共同策定したAI事業者ガイドライン(2024年4月v1.0→2025年3月v1.1)は、法的拘束力はないものの、「comply-or-explain」の基準として機能しています。このガイドラインは特にAI利用者に対して、プロンプト入力による個人情報・機密情報の漏洩リスクを明示的に警告し、AI提供者がデータを訓練に利用しないことの確認を求めています。

2025年5月28日に成立したAI推進法は日本初のAI固有法ですが、促進法であり規制法ではありません。民間事業者への唯一の義務は政府AI施策への「協力」(努力義務)で、罰則もありません。拘束力のある執行は既存法(APPI、著作権法等)に委ねられています。

APPI改正の行方 —— 2027年施行の改正法に注目

APPIは3年ごとに見直しが行われます。2025年3月にPPCが提示した案には、統計情報作成(AI開発含む)のみに使用する場合の要配慮個人情報の同意なし取得を許容する緩和策が含まれていますが、一方で行政制裁金制度の導入も検討されています。改正法案は2026年通常国会への提出、2027年施行が見込まれます。

これは弁護士にとって重要な情報です。現在は罰則の緩い日本のAI規制環境が、2027年以降は行政制裁金付きの強化された規制に移行する可能性があるということです。

日弁連の警告 —— 「5つのポイント」が示す方向性

日弁連は2023年6月にAI戦略ワーキンググループを設置し、「弁護士業務における生成AIの利活用等に関する注意事項〜適切な利活用に向けた5つのポイント〜」を作成しました。

守秘義務の観点からの警告は明確です。クラウドベースのAIサービスへの依頼者情報の入力は、外部サーバーへのデータ送信に該当し、機密漏洩リスクを生じさせます。 2024年6月1日に施行された弁護士情報セキュリティ規程は、クラウドAIツール利用時の契約上のセキュリティ確保を求めています。

日本弁理士会も2025年4月に同様のガイドラインを公表しており、士業全体としてAI利用時の個人データ保護に対する意識が高まっています。

第5章:企業の対応から学ぶ —— 「全面禁止」から「統制された利用」へ

サムスン事件 —— 企業のAIポリシーを変えた転換点

世界の企業がAI利用ポリシーの策定に動くきっかけとなったのが、2023年4月のサムスン事件です。

サムスンの半導体部門エンジニアが3件の事案で、独自のソースコード、チップ検査シーケンス、機密会議メモをChatGPTに入力しました。これらの企業秘密がOpenAIのデータセットに組み込まれてしまったのです。サムスンは2023年5月に全社的な生成AI禁止令を発出し、違反者には解雇の可能性を警告しました。

金融セクターではJPモルガン、ゴールドマン・サックス、バンク・オブ・アメリカ、シティグループ、ドイツ銀行がいずれも2023年前半にChatGPTを制限・禁止。テクノロジーセクターでもAppleが社内でのChatGPTとCopilotの使用を禁止し、Amazonは機密情報の入力を警告、Verizonは企業システムからのアクセスをブロックしました。

「シャドーAI」問題と現在の主流モデル

しかし、全面禁止は新たな問題を生みました。「シャドーAI」——従業員が個人端末で無許可のAIツールを使用し、組織として管理できないまま、より大きなリスクを生む現象——が発生したのです。

この教訓を経て、2024〜2025年にかけて企業の主流は「ガードレール付き統制利用」モデルに移行しました。その構成要素は以下の通りです。

- 承認済みAIツールリストの策定

- データ分類に基づく赤(禁止)・黄(要承認)・緑(許可)の利用基準

- 生の個人情報(PII)の外部AIアップロード原則禁止と、マスキング・匿名化の義務化

- Azure OpenAI・AWS Bedrock等のエンタープライズAIプラットフォームの採用(データが訓練に使用されず、顧客環境内に留まるもの)

- AI倫理委員会・ガバナンスボードの設置

ここで注目すべきは、「生PIIの外部AI送信禁止+マスキング必須」が企業レベルではすでにデファクトスタンダードになりつつあるということです。調査会社Gartnerは、2026年までに80%の組織がPIIリスクに対処するAIポリシーを正式化すると予測しています。

法律業界の動向 —— ABA正式意見512号の衝撃

法律業界では、米国弁護士会(ABA)が2024年7月29日に公表した正式意見512号が決定的な枠組みとなりました。

ABAモデル規則1.6(秘密保持義務)に基づき、弁護士はAIツールに情報を入力する前に、開示リスクの評価、契約条件の確認、データアクセス範囲の理解を義務付けられます。ノースカロライナ州は「公開AIリソースへの依頼者固有情報の入力を避けるべき」と明示し、テキサス州は2025年2月に「機密情報のAI入力に極度の注意」を求める意見を公表しました。

AmLaw 100(米国売上トップ100法律事務所)の80%がAIガバナンスボードを設置済みであり、Allen & Overy(現A&O Shearman)やClifford Chanceはエンタープライズグレードの基盤上で積極的にAIを活用しています。

つまり、世界のトップ法律事務所は「AIを使わない」のではなく、「安全な方法でAIを使う」方向に舵を切っているのです。

第6章:規制の方向は確定済み —— 争点は「速度」と「厳格さ」

7か国の動向が示す共通パターン

ここまで7か国・地域の規制動向を見てきましたが、明確な共通パターンが浮かび上がります。

第一に、「完全禁止」ではなく「条件付き許可」が圧倒的に有力な規制形態です。 EU AI Act、コロラド州AI法、日本のAI事業者ガイドライン、韓国のAI基本法のいずれも、AI利用自体を禁止するのではなく、リスクに応じた条件と保護措置を課すアプローチを採用しています。

第二に、その「条件」は各国で収斂しつつあります。 具体的には、法的根拠の明確化(同意または正当利益テスト充足)、データ保護影響評価(DPIA)の実施、透明性の確保、データ最小化と匿名化・仮名化の実施、オプトアウト権の保障、データ処理契約の締結、国際データ移転規制の遵守——これらの要素がグローバルスタンダードとして形成されつつあります。

第三に、違反時の制裁は急速に厳格化しています。 EU AI Actの最大3,500万ユーロ(売上高の7%)、韓国のAIモデル削除命令、イタリアの生成AI初GDPR罰金1,500万ユーロ、フランスによるX社への刑事捜査——これらは「規制が本気である」ことを示す実例です。

PIIマスキング・匿名化がベストプラクティスとして確立される蓋然性

以上を踏まえると、PIIマスキング・匿名化が事実上の必須要件として確立される蓋然性は極めて高いと結論づけられます。

EDPB意見28/2024が「匿名化されたモデルにはGDPRが適用されない可能性がある」と示したことは、PIIマスキング・匿名化が規制コンプライアンスの最も確実な経路であることを裏付けています。企業レベルでは既にデファクトスタンダード化が進んでおり、規制がこれに追いつく形で法的義務としても確立されていく方向にあります。

Microsoft Presidio、Private AI、Protecto AI等のPIIマスキングツールがすでに実用段階にあり、トークン化、リダクション、仮名化、合成データ置換等の技術が確立されています。「技術的に不可能」という言い訳はもはや成り立ちません。

第7章:弁護士が今すぐ取るべき具体的な対策

対策1:依頼者の個人情報を生のままAIに入力しない

これは最も基本的かつ最も重要な対策です。依頼者の氏名、住所、電話番号、事件の具体的内容をそのままChatGPTやClaudeに入力することは、守秘義務の観点からも、各国の規制動向からも、推奨できません。

対策2:PIIマスキング・匿名化を標準ワークフローに組み込む

個人を特定できる情報を匿名化・仮名化した上でAIに送信し、AIからの応答を受け取った後に元の情報に復元する——このワークフローを標準化することが、現時点で最も堅牢なコンプライアンス戦略です。

手作業で毎回匿名化するのは現実的ではありません。自動化されたPIIマスキングシステムの導入が事実上必要です。

対策3:エンタープライズグレードのAIプラットフォームを選択する

消費者版のChatGPT(無料版・Plus版)ではなく、データが訓練に使用されず、顧客のクラウド環境内に留まることが契約上保証されたエンタープライズ版のAIプラットフォームを採用することが推奨されます。

対策4:AI利用ポリシーを策定・文書化する

事務所としてのAI利用ポリシーを明文化しましょう。どのAIツールを使うか、どのような情報を入力してよいか、マスキングの手順はどうするか——これらを文書化しておくことは、万が一の際のリスク軽減にもつながります。

対策5:依頼者への説明と同意取得の要否を検討する

「依頼者への説明が必要なら、弁護士事務所はAIを使わない」——これは多くの先生方の本音でしょう。実際、依頼者に対して「あなたの情報をAIに入力します」と説明し同意を得るプロセスは、現実的に大きな障壁となります。

だからこそ、依頼者への同意説明が不要な形でAIを利用する設計が重要なのです。PIIマスキングにより個人を特定できない状態でAIに送信すれば、「個人情報の第三者提供」に該当しない可能性が高く、依頼者への個別説明なしにAIの恩恵を受けられます。

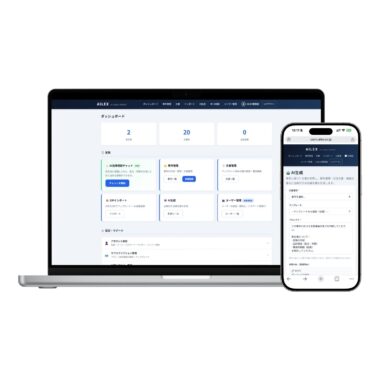

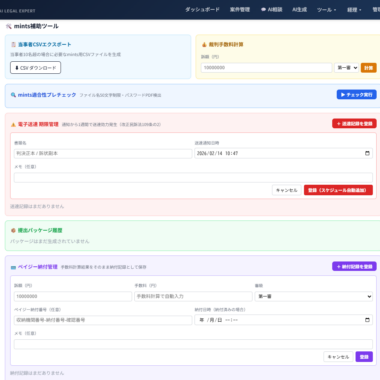

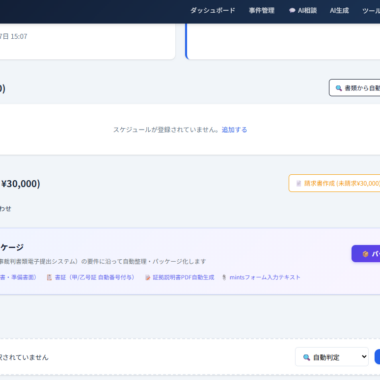

AILEXのアプローチ —— PII自動マスキングという解答

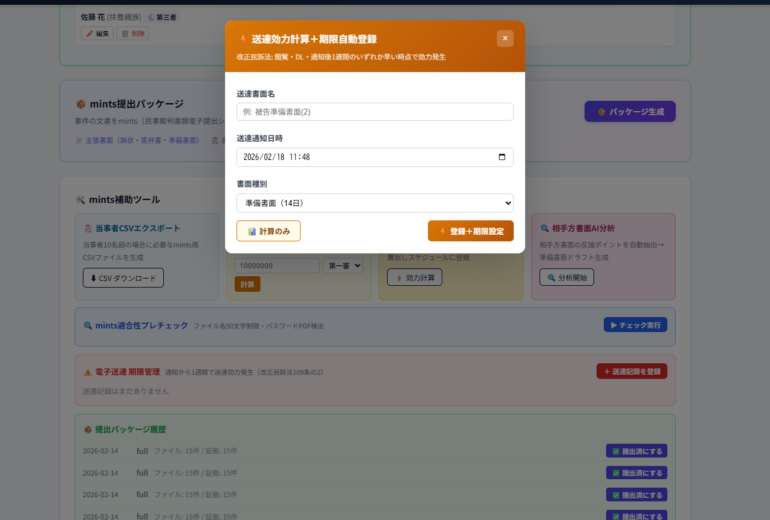

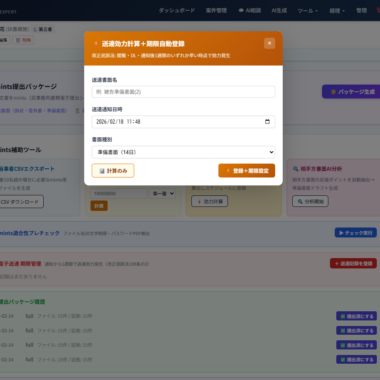

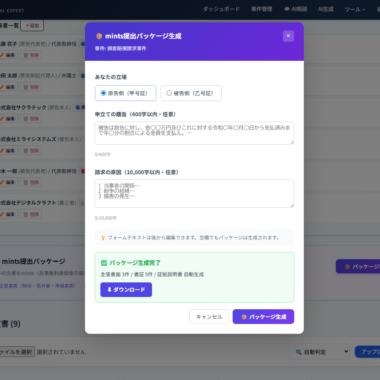

AILEXは、弁護士の守秘義務とAI活用の両立という課題に対して、PII自動マスキングという技術的解答を設計段階から組み込んでいます。

どのように機能するか

AILEXでは、弁護士がAI法律相談や文書生成機能を利用する際、入力データが外部AI API(Claude、GPT-4o等)に送信される前に、自動的にPIIマスキングが適用されます。依頼者の氏名は「甲」「乙」等のプレースホルダーに、住所・電話番号等の個人識別情報は匿名化された表現に自動置換されます。

AIからの応答を受け取った後、元の情報への復元も自動的に行われます。弁護士は特別な操作を意識することなく、通常通りAIを利用するだけで、依頼者の個人情報が外部サーバーに送信されることを防ぐことができます。

なぜこの設計が重要か

この設計には3つの重要な意味があります。

第一に、弁護士法第23条の守秘義務を技術的に保護します。 個人を特定できない状態でAIに送信するため、「機密の漏洩」のリスクを構造的に低減できます。

第二に、依頼者への同意説明が不要になります。 PIIがマスキングされた状態で外部APIに送信されるため、個人情報保護法上の「個人情報の第三者提供」に該当しない設計です。「依頼者への説明が必要なら使わない」という現場の声に応える設計思想です。

第三に、将来の規制強化に対する先行的な対応となります。 本記事で見てきたように、世界の規制はPIIマスキング・匿名化をベストプラクティスとして確立する方向に収斂しています。AILEXは規制が追いつく前に、あるべき姿を実装しています。

まとめ —— 規制の「波」は必ず来る。備えるなら今

本記事で見てきた通り、生の個人データを外部AIサービスにそのままアップロードすることに対する制約強化の方向性は、もはや不可逆的です。

完全禁止されるわけではありません。しかし、条件付き許可の「条件」は年々厳格化しており、その条件を満たさずにAIを利用し続けることのリスクは、日に日に高まっています。

日本は現時点ではEUや韓国に比べて規制が緩やかですが、2027年施行予定のAPPI改正で行政制裁金が導入される可能性があり、日弁連のガイドラインも弁護士のAI利用に対する慎重な姿勢を求めています。

「今は大丈夫」は、「これからも大丈夫」を意味しません。

弁護士がAIの恩恵を安全に享受するために、今から取るべき一歩は明確です。依頼者の個人情報を保護する仕組みを、AIの利用プロセスに組み込むこと。それが、守秘義務を守りながらAIで業務を効率化する唯一の道です。

本記事は2026年2月時点の情報に基づいています。各国の規制動向は急速に変化しており、最新の情報については各規制当局の公式発表をご確認ください。

本記事は法的助言を構成するものではありません。具体的な法的判断については、専門家にご相談ください。AILEXは弁護士の業務効率化を支援するツールであり、法律事務を行うものではありません。

AILEX — AI Legal Expert System

🔐 検証可能なAIリーガルOS

AILEX合同会社

〒150-0043 東京都渋谷区道玄坂1-10-8 渋谷道玄坂東急ビル

https://ailex.co.jp

info@ailex.co.jp

公式LINE: https://lin.ee/P9JAWZp

コメント